Con un millón de usuarios en tan solo cinco días tras su presentación, el chatbot ChatGPT se ha convertido en todo un fenómeno. Capaz de dialogar con los usuarios, sus creadores han querido evitar posibles polémicas como la que rodeó a Tay en 2016, el chatbot de Microsoft accesible mediante Twitter, al que la compañía de Redmond tuvo que retirar en apenas 24 horas, después que emitiera opiniones racistas y sexistas, tales como empatizar con las teorías raciales nazis.

ChatGPT ha sido alimentado con el contenido de Internet disponible hasta 2021, pero dicho contenido ha pasado por un filtro para etiquetar debidamente los contenidos violentos, sexistas y racistas, extraídos en algunos casos de los sótanos más recónditos de la red global.

La parte inicial de este trabajo de etiquetar los contenidos no adecuados, debe ser realizada por parte de operadores humanos, una tarea que OpenAI (compañía creadora de ChatGPT) decidió externalizar en Sama, un contratista independiente que tiene su sede central en San Francisco, pero que contrata trabajadores en países en los que paga un menor salario, tales como Kenia, Uganda e India, que etiquetan no solamente los contenidos de OpenAI, sino también los de Google, Meta y Microsoft.

Para la realización de dicha tarea, Sama confió en trabajadores kenianos, que han hablado en exclusiva para la revista Time, quejándose de sus condiciones laborales.

Para empezar, su salario no supera los dos dólares/euros la hora, pero lo peor es el tipo de contenido explícito con el que tienen que lidiar: abuso sexual infantil, bestialidad, asesinato, suicidio, tortura, autolesión o incesto.

Como ejemplo, uno de los trabajadores habla de “tortura” al tener que leer y etiquetar la descripción explícita de una escena en la que un hombre practicaba sexo con un perro en presencia de un niño.

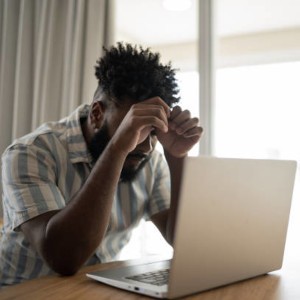

La lectura de contenidos de este tipo a lo largo de toda la semana deja traumas y consecuencias psicológicas, que chocan frontalmente con la definición de “IA ética” que hace Sama de su trabajo. La misma compañía también afirma -y de ello se hace eco Time en su artículo- que ha sacado a más de 50.000 personas de la pobreza. No explicita si también se ha hecho cargo de sus tratamientos psicológicos a posteriori...

La revista Time también ha tenido acceso a documentación interna tanto de OpenAI como de Sama, entre la que se encuentran nóminas de los trabajadores de esta última.

La tarea llevada a cabo por los trabajadores kenianos fue interrumpida abruptamente bastante antes de lo pactado entre ambas compañías, aunque ChatGPT ya tiene su propio motor entrenado que es capaz de distinguir entre el contenido no adecuado, y el adecuado.